RAG: Маст хэв для умных приложений на LLM

RAG (Retrieval-Augmented Generation) — это архитектура, которая революционизирует работу с большими языковыми моделями (LLM), позволяя им получать доступ к актуальным и специализированным данным.

💯 Самая популярная архитектура

В сочетании с таким инструментом, как Ollama, для локального запуска моделей, RAG открывает возможность создания мощных и конфиденциальных интеллектуальных систем, работающих на ваших собственных данных.**

Что такое RAG и почему он так важен?

Retrieval-Augmented Generation (RAG) — это методика, которая расширяет возможности больших языковых моделей (LLM), добавляя этап поиска информации во внешних базах знаний перед генерацией ответа пользователю. В отличие от традиционных LLM, которые полагаются исключительно на статичные данные, на которых они были обучены, RAG-система может обращаться к новейшим исследовательским работам, внутренним документам компании или любым другим указанным источникам, чтобы давать точные и релевантные ответы.

Популярность этой архитектуры объясняется её способностью решать фундаментальные проблемы стандартных LLM:

1️⃣ Статичность знаний: Модели застывают в моменте своего последнего обучения и не знают о более поздних событиях. RAG решает это, подключая модель к живым источникам данных.

2️⃣ Галлюцинации: LLM иногда склонны генерировать правдоподобный, но фактически неверный текст. RAG значительно снижает этот риск, "заземляя" модель на извлеченные факты.

3️⃣ Экономическая эффективность: Полное переобучение LLM на новых данных требует колоссальных вычислительных ресурсов и затрат. RAG предлагает более легкий альтернативный путь, экономя время и деньги.

Как работает RAG: от запроса к ответу

Процесс работы RAG можно разбить на три ключевых этапа, которые происходят каждый раз, когда пользователь задает вопрос.

1. Индексация (Подготовка данных)

На этом этапе внешние данные (документы, базы знаний, веб-страницы) проходят предварительную обработку. Текст разбивается на логические фрагменты (чанки), которые затем с помощью моделей эмбеддингов преобразуются в числовые представления — векторы. Эти векторы хранятся в специальной векторной базе данных, которая в дальнейшем позволяет быстро находить семантически близкие фрагменты текста.

2. Извлечение (Поиск информации)

Когда пользователь задает вопрос, его запрос также преобразуется в вектор. Система выполняет поиск в векторной базе данных, чтобы найти фрагменты текста, наиболее близкие по смыслу к запросу. Для повышения точности часто используется гибридный поиск, комбинирующий семантический (векторный) и ключевой (текстовый) поиск.

3. Генерация (Создание ответа)

Найденные релевантные фрагменты текста (контекст) вставляются в промпт к LLM вместе с оригинальным вопросом пользователя. Модель, вооруженная актуальными и проверенными данными, генерирует точный, связный и информативный ответ, часто со ссылками на источники.

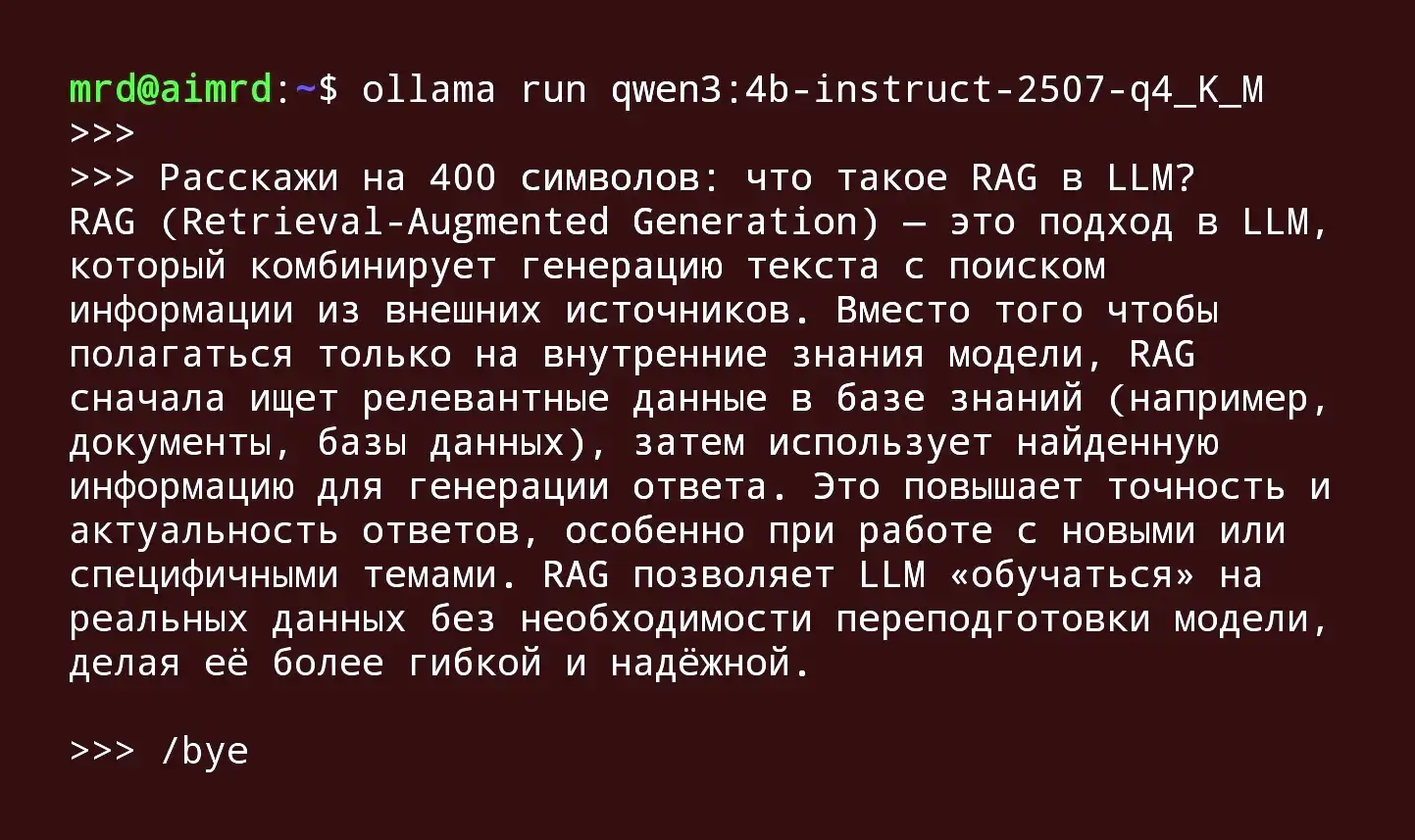

Роль Ollama в экосистеме RAG

Ollama — это фреймворк с открытым исходным кодом, предназначенный для простого и эффективного локального запуска больших языковых моделей. В контексте RAG Ollama идеально подходит на роль движка генерации.

Статьи про Оллама

✅ Локальность и конфиденциальность: Поскольку Ollama работает на вашем собственном оборудовании, ваши данные никогда не покидают периметр вашей инфраструктуры. Это критически важно для работы с конфиденциальными документами, коммерческой тайной или персональными данными.

✅ Простота использования: Ollama абстрагирует сложности настройки и развертывания моделей, предлагая простой в использовании API, что ускоряет разработку.

✅ Гибкость выбора моделей: Ollama поддерживает широкий спектр современных моделей с открытым исходным кодом, таких как LLaMA от Meta, Mistral и многие другие, позволяя выбрать оптимальное решение для конкретной задачи.

Стек технологий для локального RAG с использованием Ollama может выглядеть так: в качестве фреймворка для оркестрации используется LangChain, векторная база данных — FAISS или Chroma, модель для эмбеддингов — sentence-transformers, а Ollama выступает в роли локального движка LLM для генерации финального ответа.

Преимущества и вызовы архитектуры RAG

Ключевые преимущества

- Доступ к актуальным и специализированным знаниям: RAG позволяет LLM работать с самой свежей информацией и данными конкретного домена, которые не входили в её исходный тренировочный набор.

- Повышение доверия пользователей: Возможность указывать источники информации позволяет пользователям проверять достоверность ответов, что повышает общий уровень доверия к системе.

- Контроль и безопасность: Организации могут строго контролировать, к каким данным модель имеет доступ, обеспечивая соответствие политикам безопасности и нормативным требованиям.

Проблемы и ограничения

- Зависимость от качества данных: Эффективность RAG напрямую зависит от качества и организации исходных данных. Беспорядочно сохраненная информация может привести к извлечению нерелевантных документов.

- Отсутствие итеративного мышления: Стандартная RAG-система не "размышляет" над вопросом в несколько шагов. Если в первом раунде поиска не были найдены нужные документы, система не сможет сама переформулировать запрос и попробовать снова.

- Риск некорректной интерпретации: Даже при извлечении фактчески верных источников LLM может неверно интерпретировать их контекст, что приведет к ошибочному выводу.

Эволюция RAG: от простой к сложной архитектуре

Базовый подход к RAG постоянно развивается, появляются более сложные архитектуры, призванные преодолеть его первоначальные ограничения.

1️⃣ Corrective RAG (CRAG): Внедряет механизм самопроверки, который оценивает и фильтрует извлеченные документы на предмет релевантности, прежде чем передать их модели для генерации. Если качество документов низкое, система может autonomously выполнить веб-поиск для дополнения информации.

2️⃣ Self-RAG: Модель сама решает, нужно ли ей обращаться к внешним данным для конкретной части запроса, и может динамически генерировать несколько запросов в процессе генерации ответа, что особенно полезно для сложных и составных вопросов.

3️⃣ Adaptive RAG: Динамически выбирает стратегию в зависимости от сложности запроса. Для простых фактологических вопросов может использоваться прямая генерация без поиска, а для сложных — полный RAG-цикл, что оптимизирует производительность и стоимость.

Заключение

RAG утвердилась в качестве самой популярной архитектуры для создания интеллектуальных приложений на LLM не случайно. Она предлагает практичный, экономически эффективный и мощный способ наделить языковые модели актуальными и релевантными знаниями, преодолевая их врожденные ограничения.

В сочетании с такими инструментами, как Ollama, который делает передовые LLM доступными для локального развертывания, RAG открывает эру умных, безопасных и конфиденциальных ассистентов, способных трансформировать работу с информацией в бизнесе, науке и образовании.

Будущее этой технологии лежит в создании еще более адаптивных, "мыслящих" и надежных систем, которые станут по-настоящему интеллектуальными партнерами человека.

Опубликовано: