Ollama: Техническое ядро и выбор модели

Возможность запускать современные языковые модели на обычном центральном процессоре — это ключевая особенность Ollama, которая демократизирует доступ к ИИ.

Мозги и память: Как работают локальные AI-модели и как выбрать свою

Сервер без видеокарты?

Решающую роль играет оперативная память (RAM)

В то время как мощные видеокарты (GPU) ускоряют вычисления за счет тысяч параллельных ядер, они не являются обязательными. Механизм работы Ollama без GPU радикально меняет требования к системе: видеопамять больше не играет роли, а вся тяжесть вычислений и хранения данных ложится на центральный процессор и, что еще важнее, на оперативную память сервера.

Статьи по теме

Принцип работы

Почему CPU и RAM заменяют GPU

Когда вы запускаете модель в Ollama без графического ускорителя, система использует высокооптимизированные библиотеки для CPU (такие как BLAS и родные для Ollama вычисления). Вся архитектура нейронной сети, включая ее многослойные веса и параметры, должна быть загружена в быструю память, доступную процессору, — то есть в оперативную память (RAM). В отличие от сценария с GPU, где у модели есть доступ к специализированной видеопамяти (GDDR), здесь используется общая системная RAM.

💯 Это приводит к простому, но критически важному правилу: чем больше параметров у модели, тем больше оперативной памяти ей требуется для работы.

Каждый параметр — это число с плавающей запятой, и для его хранения и манипуляций во время генерации текста нужны соответствующие объемы RAM. Процесс генерации ответа — это не просто поиск по базе, а последовательность сложных матричных умножений, выполняемых процессором непосредственно в оперативной памяти, где размещена модель.

Перечень, поиск и описание моделей Ollama

Как рассчитать нагрузку на RAM

Практическое руководство

Чтобы избежать сбоев и замедления работы системы, жизненно необходимо заранее оценить, хватит ли вашим серверам ресурсов для выбранной модели. Расчет строится на простой, но эффективной формуле.

Базовый объем

Первым делом необходимо узнать размер самой модели. Как правило, он прямо указан в ее названии или описании в репозитории Ollama. Например, популярная 7-миллиардная модель llama3 в стандартном формате занимает около 4.1 ГБ дискового пространства.

Эта цифра — отправная точка для расчета ее «аппетита» к RAM.

Критический оверхед

Недостаточно просто выделить объем, равный размеру файла модели. В процессе работы Ollama требуется дополнительная оперативная память для служебных задач. Этот «оверхед» может составлять от 20% до 30% от размера модели и тратится на:

- Обработку контекста: Хранение истории вашего диалога с моделью (контекстного окна). Чем длиннее ваш запрос и предыдущие ответы, тем больше памяти нужно для их учета.

- Кеши ключей и значений (KV-Cache): Для ускорения генерации последовательности токенов модель кеширует промежуточные вычисления, что также потребляет RAM.

- Временные буферы: Процессор использует дополнительную память для самих вычислений.

Пример: модель на 4 ГБ может потребовать 5-6 ГБ оперативной памяти

Давайте рассмотрим конкретный пример с моделью llama3:8b (8 миллиардов параметров), чей файл весит примерно 4.7 ГБ.

- Берем базовый размер: 4.7 ГБ.

- Рассчитываем оверхед: 25% от 4.7 ГБ ≈ 1.2 ГБ.

- Суммируем: 4.7 ГБ + 1.2 ГБ = 5.9 ГБ.

Вывод: Для стабильной работы модели llama3:8b на CPU ваш сервер должен иметь как минимум 6 ГБ свободной оперативной памяти.

И это — только для самой Ollama. Если на этом же сервере работают другие процессы (веб-сервер, база данных, система), их потребности нужно прибавить к этой цифре. Поэтому для такой модели сервер с 8 ГБ RAM будет комфортным минимумом, а с 16 ГБ — обеспечит еще и запас для остальных задач.

Помните: недостаток памяти приведет не только к медленной работе, но и к полному краху процесса, когда операционная система начнет завершать приложения из-за нехватки ресурсов.

Типы моделей

От карманных ассистентов до интеллектуальных гигантов

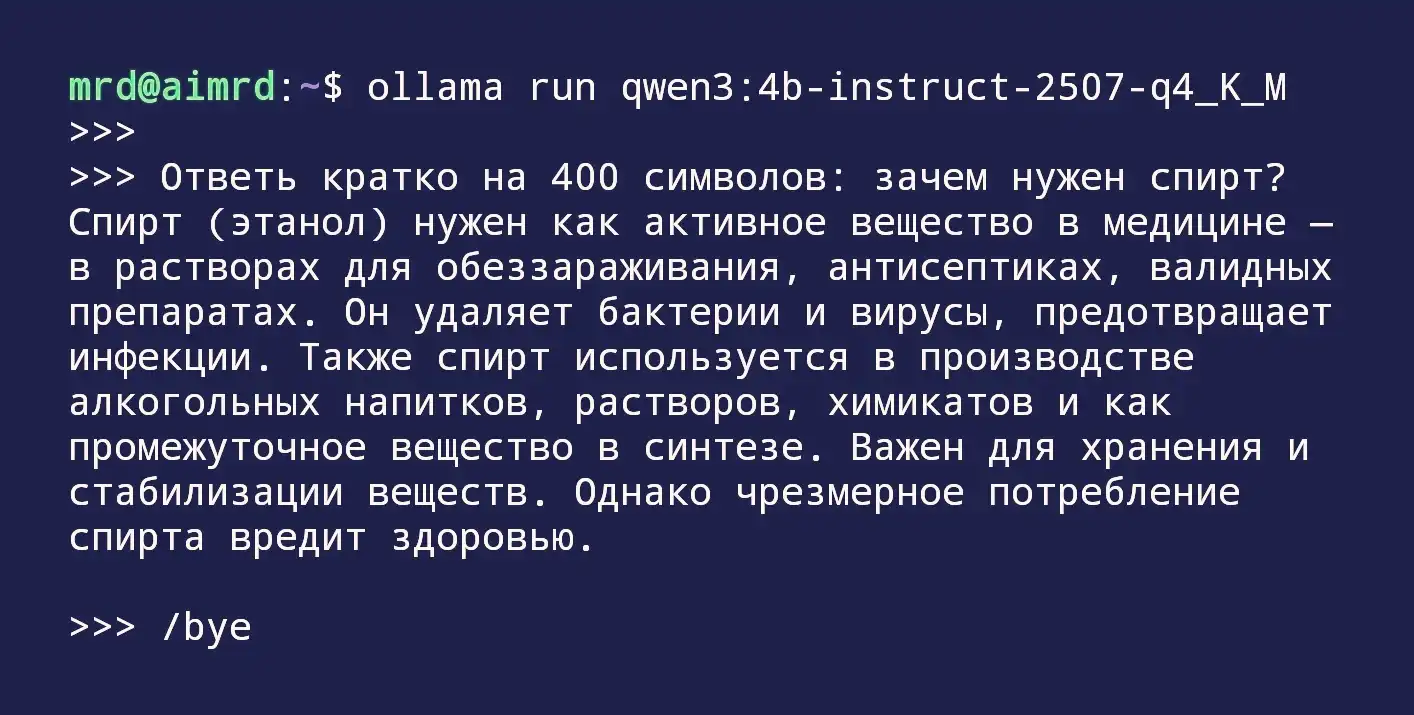

Цифра в названии модели — будь то llama3:8b, mistral:7b или tinyllama:1b — это не случайный набор символов. Это важнейший технический параметр, указывающий на количество миллиардов параметров (Billions), из которых состоит нейронная сеть.

Представьте эти параметры как синапсы в человеческом мозге: чем их больше, тем сложнее и тоньше связи, которые модель может устанавливать между понятиями.

Это прямое отражение масштаба и потенциальной мощности искусственного интеллекта. Однако за увеличение этого числа приходится платить: чем "умнее" модель, тем больше вычислительных ресурсов и оперативной памяти ей требуется для работы. Понимание этой градации — ключ к осознанному выбору инструмента, который идеально подойдет для ваших задач и вашего железа.

Модели 1B-3B

Легковесные решения для скоростных задач

Модели этого класса — это спортивные компактные автомобили мира ИИ: они не поражают воображение роскошью, но обеспечивают быстрый и эффективный результат для повседневных нужд.

Характеристики: Их главные козыри — низкие требования к оперативной памяти (обычно от 1 до 4 ГБ в зависимости от формата квантизации) и чрезвычайно высокая скорость отклика. Они загружаются за секунды и генерируют текст почти мгновенно даже на слабом процессоре.

Назначение: Эти модели созданы для конкретных, хорошо структурированных задач, где глубина понимания контекста уступает по важности скорости и предсказуемости. Идеальная сфера их применения:

- Классификация текста: Автоматическая сортировка обращений в службу поддержки, модерация комментариев, анализ тональности.

- Чат-боты с узкой специализацией: Ответы на часто задаваемые вопросы по конкретной теме, где диалог следует предопределенному сценарию.

- Базовое извлечение информации: Поиск ключевых слов, имен, дат в документе.

- Генерация простых текстов: Создание мета-тегов, заголовков, коротких описаний товаров.

Примеры

tinyllama(1.1B): Яркий пример ультракомпактной модели, демонстрирующей, что даже при минимальном размере можно получить вменяемые результаты для простых запросов.phi3:mini(3.8B): Прорыв в своем классе. Несмотря на скромный размер, благодаря качеству обучающих данных показывает результаты, сопоставимые с некоторыми 7B-моделями, оставаясь при этом очень быстрой и нетребовательной.

Модели 7B и выше

Баланс качества и потребления

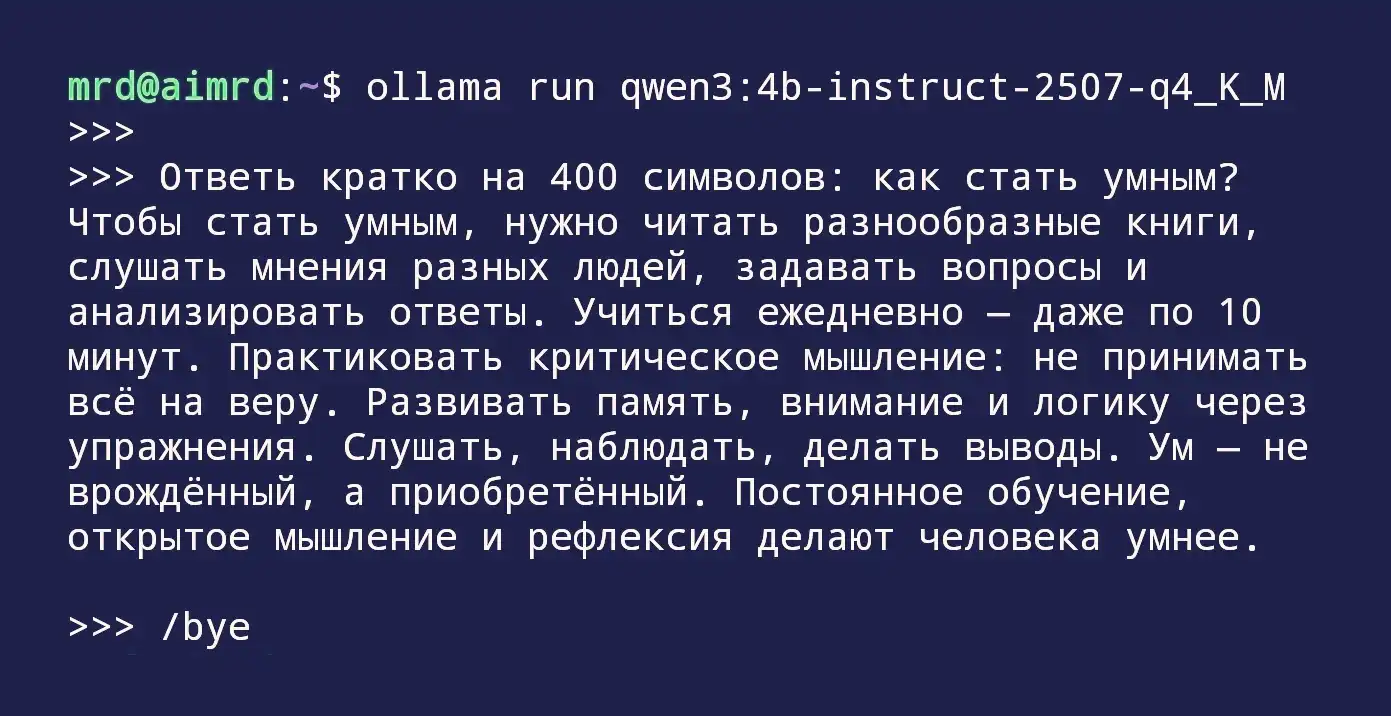

Этот сегмент — золотая середина и самый популярный выбор для пользователей Ollama. Модели с 7 до 13 миллиардов параметров переходят от выполнения простых инструкций к демонстрации настоящего понимания и рассуждения.

Характеристики: Они требуют умеренных ресурсов (для 7B-моделей нужно 4-8 ГБ RAM, для 13B — 8-16 ГБ), но предлагают качественный скачок в способностях. Их ответы становятся более связными, логичными, а контекст диалога удерживается гораздо лучше. Они способны понимать нюансы и следовать сложным многоэтапным инструкциям.

Назначение: Это уже универсальные помощники, способные справляться с широким кругом интеллектуальных задач:

- Универсальные диалоги: Поддержание свободной, осмысленной беседы на различные темы.

- Программирование и код: Написание функций, рефакторинг, дебаггинг, генерация скриптов. Специализированные модели вроде

codellamaпоказывают здесь выдающиеся результаты. - Сложные диалоги: Анализ длинных документов, написание эссе, составление бизнес-планов, творческое письмо.

- Обобщение и синтез информации: Создание конспектов из объемных статей или стенограмм встреч.

Примеры

llama2/llama3(7B): Флагманские модели от Meta, ставшие отраслевым стандартом.Llama3в частности, совершила значительный рывок в качестве и рассудительности для своего класса.mistral(7B): Французская модель, которая в свое время удивила сообщество своей эффективностью, превзойдя по ряду задач более крупных конкурентов. Славится своим острым "интеллектом".codellama(7B/13B): Специализированная версия Llama, дообученная на огромных объемах кода. Лучший выбор для любых задач, связанных с программированием.qwen(7B): Мощная модель от Alibaba, известная своей хорошей многоязычной поддержкой, включая русский язык.

Выбор между этими типами — это всегда компромисс.

Легковесные модели — это инструмент для конкретной работы, который всегда под рукой. Модели класса 7B и выше — это уже интеллектуальные партнеры, способные на творчество и сложные рассуждения, но требующие за это более солидных аппаратных "инвестиций".

Практика

Выбираем модель под конфигурацию сервера

Теоретическое понимание различий между моделями важно, но именно на практике возникает ключевой вопрос: «Какая модель запустится на моем сервере и что я смогу от нее получить?». Правильный подбор — это не поиск самой «умной» модели, а поиск оптимальной, чьи аппетиты к RAM полностью соответствуют возможностям вашего железа. Давайте рассмотрим три типичных сценария, чтобы вы могли сразу определить свою отправную точку.

Сервер с 2-4 ГБ RAM

Экономный трудяга для элементарных задач

Такая конфигурация характерна для маломощных виртуальных машин, старых компьютеров или микросерверов (например, на базе Raspberry Pi 5 с 4-8 ГБ). Здесь каждый мегабайт памяти на счету.

Рекомендация: Модели класса 1B-3B. Ваш выбор будет ограничен самыми компактными вариантами, но и они способны на многое.

Примеры:tinyllama:1.1b, phi2:3b, qwen:1.8b. Эти модели занимают на диске от 700 МБ до 2 ГБ, что после учета служебного оверхеда укладывается в доступный лимит RAM.

Что можно ожидать

- Скорость: Мгновенная загрузка и практически отсутствующие задержки при генерации ответа.

- Качество ответов: Ответы будут краткими, буквальными и лишенными глубокого анализа. Модель хорошо справляется с простыми инструкциями: «перефразируй это предложение», «классифицируй отзыв как положительный или отрицательный», «извлеки из текста дату и место».

- Ограничения: Модель может «галлюцинировать» (придумывать факты) при сложных запросах, быстро терять нить контекста в длинном диалоге и с трудом понимать многослойные инструкции.

- Идеальное применение: Автоматизация рутинных задач — сортировка писем, генерация мета-тегов, простейшие чат-боты-консультанты с фиксированными сценариями.

Сервер с 8-16 ГБ RAM

Золотая середина для большинства проектов

Это стандартная конфигурация для современных VPS и выделенных серверов начального и среднего уровня. Здесь открывается доступ к самым популярным и сбалансированным моделям, которые и принесли Ollama широкую известность.

Рекомендация: Модели класса 7B-8B. Это наиболее развитый и тестируемый сегмент, предлагающий отличное соотношение интеллекта и потребления.

Примеры:llama3:8b, mistral:7b, codellama:7b, qwen:7b. Их работа потребует 6-10 ГБ оперативной памяти, что оставляет достаточно места для операционной системы и других фоновых процессов.

Что можно ожидать

- Качество текста: Связные, хорошо структурированные и грамотные ответы. Модель начинает демонстрировать логическое мышление, способность к обобщению и понимание причинно-следственных связей.

- Решение задач: Способность писать простой и средний по сложности код, решать логические головоломки, составлять планы и проводить сравнительный анализ.

- Контекст: Гораздо лучше удерживает контекст длинного диалога (до нескольких тысяч токенов), что позволяет вести осмысленные продолжительные беседы.

- Идеальное применение: Универсальный AI-ассистент для программирования, создания контента (статьи, посты, сценарии), обучения, анализа данных и создания интеллектуальных чат-ботов с широкой специализацией.

Сервер с 32+ ГБ RAM

Мощь для сложных рассуждений и экспертных задач

Серверы с таким объемом памяти позволяют работать с тяжеловесами мира локального ИИ, приближая качество генерации к уровню коммерческих облачных решений.

Рекомендация: Модели класса 13B, 34B и даже 70B+ (в квантованных версиях). Квантование позволяет «ужать» большую модель, сохранив значительную часть ее способностей, но снизив требования к памяти в 2-3 раза.

Примеры:llama3:70b (в 4-битном квантовании q4_0 требует ~40 ГБ), qwen:14b, mixtral:8x7b (мощная смесь экспертов). Для 70B-моделей в квантовании q4_0 требуется около 40 ГБ RAM, что делает их доступными для серверов с 64 ГБ памяти.

Что можно ожидать

- Глубина понимания: Модель улавливает тонкие нюансы, иронию, подтекст и сложные метафоры. Ее ответы становятся глубокими и содержательными.

- Сложные рассуждения: Способность к дедукции, проведению многоэтапных исследований, генерации сложных аргументированных текстов и решению нестандартных задач.

- Экспертность: Может выступать в роли узкоспециализированного эксперта — юриста, финансиста, научного сотрудника — демонстрируя глубокие знания в конкретной области.

- Идеальное применение: Создание исследовательских ассистентов, сложных аналитических систем, автоматизация написания технической и научной документации, а также любые задачи, где требуется максимально возможное на локальном железе качество генерации.

Опубликовано: