Ollama: Решение проблем и тонкая настройка

Вы успешно установили Ollama, подобрали идеальную модель для своего сервера и даже протестировали ее через командную строку. Все работает безупречно.

Секреты настройки Ollama: CORS, кириллица и другие подводные камни

Важный нюанс

Настройка CORS через OLLAMA_ORIGINS

Но как только вы пытаетесь создать собственный веб-интерфейс или подключить к Ollama фронтенд-приложение, запущенное в браузере, — происходит непонятное: запросы не проходят, а в консоли разработчика красуется ошибка «CORS policy». Это не баг Ollama и не ошибка в вашем коде. Это срабатывает встроенный механизм безопасности современных браузеров, и для работы с ним существует простое и элегантное решение.

Что такое CORS и почему он мешает?

CORS (Cross-Origin Resource Sharing) — это не враг, а страж. Это стандартный механизм безопасности, реализованный во всех современных браузерах. Его задача — предотвращать потенциально опасные межсайтовые запросы.

Он работает по простому правилу: если ваш фронтенд (например, веб-сайт на http://localhost:3000) пытается сделать запрос к бэкенду (Ollama на http://localhost:11434) через JavaScript, браузер считает это небезопасным, так как источники (порты) различаются.

С точки зрения браузера, это два разных «происхождения» (origin).

Даже если и фронтенд, и бэкенд работают на одном физическом сервере (localhost), но на разных портах — для браузера это потенциальная угроза. В результате он *блокирует такой запрос', чтобы злонамеренный скрипт с одного сайта не мог без вашего ведома украсть или изменить данные с другого. Именно это и происходит, когда ваш красивый веб-чат пытается «позвонить» Ollama API — браузер настойчиво говорит «нет».

Статьи по теме

Решение одной переменной

OLLAMA_ORIGINS

К счастью, создатели Ollama предусмотрели эту ситуацию. Проблема решается не изменением кода приложения, а правильной настройкой сервера Ollama с помощью одной-единственной переменной окружения — OLLAMA_ORIGINS.

Эта переменная сообщает серверу Ollama: «Я доверяю запросам, которые приходят с такого-то адреса». Когда сервер получает запрос, он проверяет заголовок Origin, отправленный браузером. Если этот источник совпадает с одним из указанных в OLLAMA_ORIGINS, сервер добавляет в ответ специальный заголовок Access-Control-Allow-Origin, который является для браузера зеленым сигналом: «Этот источник разрешен, пропусти запрос».

Практическое применение

1️⃣ Для нативного запуска: Просто установите переменную окружения перед запуском сервиса.

export OLLAMA_ORIGINS="http://localhost:3000"- Затем запустите Ollama как обычно:

ollama serve

2️⃣ Для запуска в Docker: Передайте переменную при создании контейнера с помощью флага -e (environment).

docker run -d -p 11434:11434 -e OLLAMA_ORIGINS="http://localhost:3000" --name ollama ollama/ollama

3️⃣ Вариации значения

- Для локальной разработки:

OLLAMA_ORIGINS="http://localhost:3000"(если ваш фронтенд на React/Vue на порту 3000). - Для нескольких адресов: Можно перечислить их через запятую:

OLLAMA_ORIGINS="http://localhost:3000,https://mydomain.com". - Для продакшена:

OLLAMA_ORIGINS="https://your-production-domain.com".

÷Важно помнить, что эту настройку нужно производить до запуска сервера Ollama.

Если вы изменили переменную, сервер необходимо перезапустить. Потратив 30 секунд на эту настройку, вы раз и навсегда избавите себя от часов отладки, пытаясь понять, почему ваш идеальный фронтенд не может «достучаться» до работающего в соседней вкладке терминала бэкенда. Это небольшой, но критически важный шаг на пути к созданию полноценного веб-приложения на основе локального ИИ.

Работа с кириллицей

Как не промахнуться с моделью

Ollama как платформа абсолютно нейтральна к языкам — она с одинаковой легкостью передает байты с английскими, русскими или китайскими символами. Однако способность искусственного интеллекта понимать суть вашего вопроса и генерировать осмысленный, грамотный ответ на русском языке — это свойство не движка, а самой языковой модели. Оно напрямую зависит от того, на каких данных модель обучалась. Если ее «диета» состояла преимущественно из англоязычных текстов, ждать от нее глубокого понимания тонкостей русского языка бессмысленно. Поэтому выбор модели, способной работать с кириллицей, — это отдельная важная задача.

Признаки «русскоязычной» модели

Чтобы избежать разочарований, при выборе модели обращайте внимание на несколько ключевых маркеров, указывающих на поддержку русского языка.

1️⃣ Прямое указание в описании. Самый надежный признак — когда создатели модели явно пишут об этом в документации или описании. Ищите в официальном репозитории Ollama (ollama run list) или на странице модели на платформе Hugging Face фразы вроде: «supports multiple languages, including Russian», «multilingual», «Russian language support». Например, модели серии qwen и deepseek часто позиционируются как мультиязычные.

2️⃣ Специализированные и дообученные модели. Существуют модели, которые были целенаправленно дообучены на больших корпусах русскоязычных текстов. Они могут быть основаны на известных архитектурах (например, Llama или Mistral), но после дополнительного обучения показывают гораздо лучшие результаты в понимании контекста, грамматики и специфических для русской культуры понятий. Названия таких моделей часто содержат указания на регион, например, solar-russian.

Как проверить модель перед использованием?

Не стоит полагаться на удачу. Потратьте несколько минут на проверку, чтобы убедиться, что модель соответствует вашим языковым требованиям.

1. Изучите документацию. Первым делом зайдите в библиотеку моделей Ollama (ollama.com/library) или на соответствующую страницу на Hugging Face (huggingface.co). Внимательно прочтите описание модели, раздел «Languages» или посмотрите на метки (tags). Часто там содержится исчерпывающая информация о поддерживаемых языках.

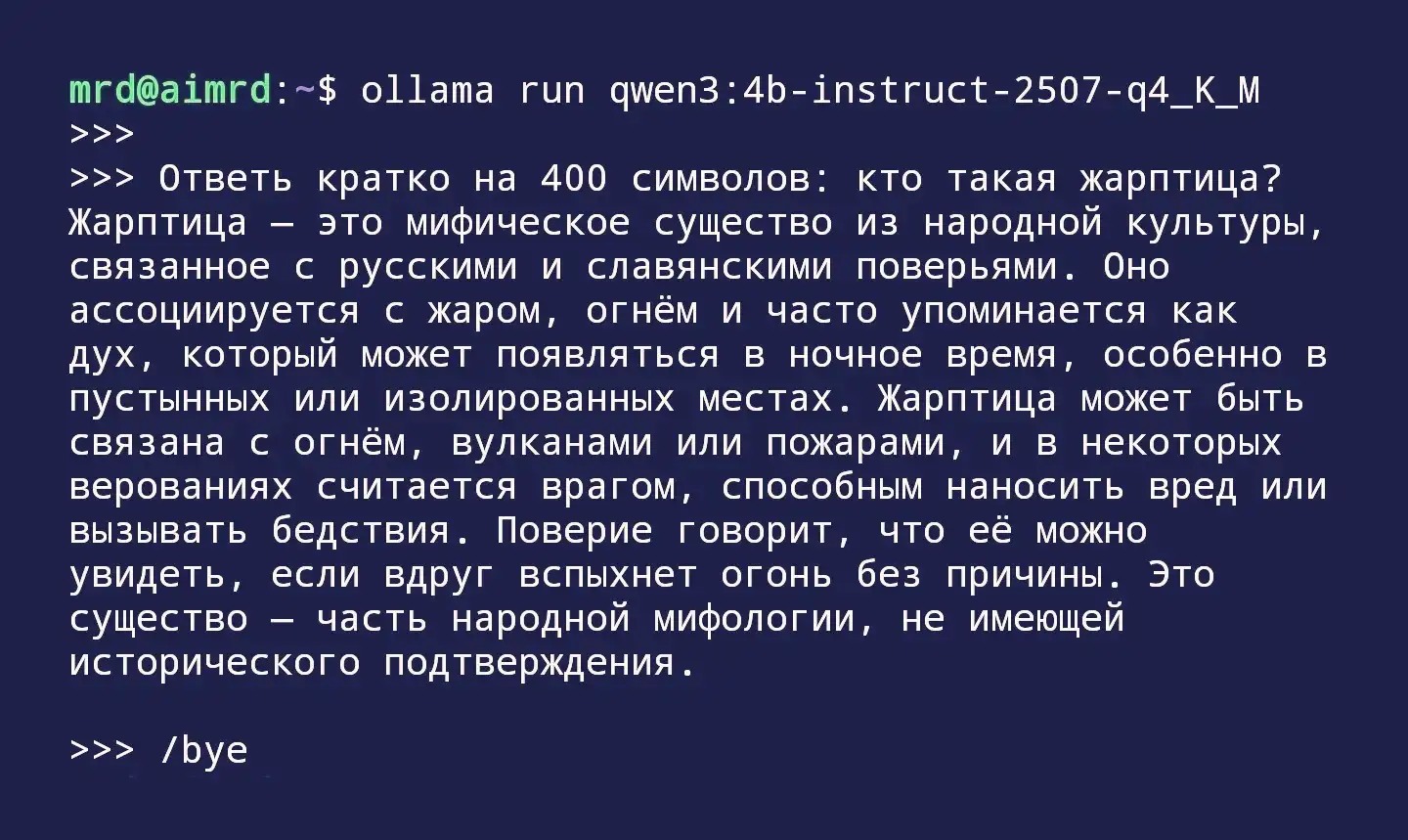

2. Проведите полевой тест. После того как вы скачали модель (ollama pull <model_name>), проведите с ней небольшое собеседование. Задайте тестовый вопрос, который требует понимания контекста, а не просто поиска по шаблону.

🛃 Плохой тест: «Напиши слово 'привет' на русском». Это может сработать даже у чисто английской модели, просто скопировавшей слово из обучающих данных.

🏡 Хороший тест: Задайте вопрос на знание локального контекста или синонимов: «Объясни разницу между словами 'предать' и 'передать'» или «В чем заключается парадокс Банаха-Тарского?». Качественная русскоязычная модель даст внятное, связное объяснение, в то время как слабая может сгенерировать бессмыслицу или перейти на английский.

Помните: если для вашего проекта принципиально важна работа с кириллицей, выбор и тестирование модели — это не опциональный шаг, а строгая необходимость. Правильно подобранная модель станет полноценным собеседником или помощником, в то время как неподходящий вариант создаст лишь иллюзию работы и принесет разочарование.

Опубликовано: