Ollama: Знакомство и быстрый старт

Ollama — это не просто инструмент, а ваш пропуск в мир локальных больших языковых моделей (LLM), где мощный GPU — опция, а не необходимость.

Ваш карманный ИИ на любом сервере. Как запустить языковые модели без видеокарт и не наступить на грабли

Ollama — это фреймворк для локального запуска больших языковых моделей (LLM, Large Language Model) на основе CPU и RAM

Этот движок позволяет развертывать и использовать современные AI-модели, подобные ChatGPT, прямо на вашем собственном железе, обеспечивая полный контроль над данными и их обработкой. Ключевое преимущество, которое делает Ollama столь популярной, — ее способность работать исключительно на центральном процессоре, что кардинально меняет правила игры для владельцев стандартных Linux-серверов.

Однако, простота установки обманчива. Чтобы система работала стабильно и эффективно, необходимо учитывать несколько фундаментальных аспектов, которые и станут залогом вашего успеха.

Статьи по теме

Что нужно понять перед первым запуском

1️⃣ Гибкость развертывания. Ollama можно установить нативно, одной командой в терминале, или запустить в изолированном Docker-контейнере, что является предпочтительным способом для продакшн-среды благодаря простоте управления и переносимости.

2️⃣ Оперативная память — новый видеопроцессор. При отсутствии видеокарты вся модель загружается в оперативную память (RAM). Это означает, что объем доступной RAM — главный лимитирующий фактор. Чем ее больше, тем более мощную и качественную модель вы сможете использовать.

3️⃣ Обязательная настройка для веб-доступа. Если вы планируете обращаться к Ollama через веб-браузер или собственный фронтенд, вы неизбежно столкнетесь с ошибками CORS (межсайтовой защиты). Решение — одна переменная окружения OLLAMA_ORIGINS, которую нужно задать до запуска, указав адрес вашего приложения. Игнорирование этого шага — самая частая причина, почему «ничего не работает» после установки.

4️⃣ Модели бывают разные: выбирайте с умом. Модели для Ollama классифицируются по размеру (1B, 3B, 7B, 13B и т.д., где «B» — миллиарды параметров). Эта цифра — прямой индикатор их «прожорливости» к RAM и потенциальной интеллектуальной мощи. Компактные модели (1B-3B) быстры и нетребовательны, но проигрывают в качестве моделям побольше (7B+). Правило простое: подбирайте модель под доступные ресурсы вашего сервера.

5️⃣ Поддержка русского — вопрос обучения модели, а не движка. Сам по себе Ollama одинаково хорошо работает с людьми и кодом на любом языке. Но способность модели понимать и генерировать текст на кириллице зависит исключительно от данных, на которых ее обучали. Перед использованием всегда проверяйте описание модели на предмет поддержки русского языка.

Таким образом, успешное внедрение Ollama упирается не в сложность программирования, а в стратегическое планирование: адекватная оценка ресурсов сервера, выбор подходящей модели и несколько минут на правильную первоначальную настройку.

Что такое Ollama?

В самом начале бума больших языковых моделей работа с ними напоминала искусство для избранных. Чтобы запустить на своем компьютере что-то более мощное, чем демо-пример, требовались глубокие познания в Python, умение работать с низкоуровневыми фреймворками вроде llama.cpp или библиотекой Transformers от Hugging Face, а также готовность потратить часы на разрешение зависимостей и конфликтов версий.

Ollama стала тем самым инструментом, который демократизировал этот процесс, превратив его из удела инженеров-энтузиастов в доступную технологию для разработчиков, исследователей и даже технически подкованных обывателей.

Решаемая проблема: от сложности к простоте

✅ До Ollama: Процесс запуска модели выглядел как многоэтапный квест. Нужно было скачать десятки гигабайтов весов модели с Hugging Face, правильно сконвертировать их в нужный формат, собрать и скомпилировать C++ бэкенд (тот же llama.cpp), написать свой скрипт-обвязку на Python для взаимодействия с API, а затем бороться с ошибками совместимости.

💯 Это была огромная преграда на пути массового adoption локального ИИ.

✅ После Ollama: Процесс свелся к интуитивно понятным командам в терминале. Установка — одна команда. Запуск модели — другая команда: ollama run llama3. Вся сложность — конвертация, управление моделями, предоставление API — была спрятана под капотом продуманного и дружелюбного интерфейса. Это позволило сосредоточиться на использовании моделей, а не на их запуске.

Ключевые особенности платформы

Ollama — это не просто скрипт-установщик, а полноценная платформа для управления и работы с LLM, что и объясняет ее стремительную популярность.

1️⃣ Простота использования. Как уже было отмечено, это главный приорисс. Пользователь получает готовый к работе инструмент без необходимости погружаться в тонкости машинного обучения.

2️⃣ Централизованный хаб моделей. В Ollama встроена собственная библиотека *Ollama Library**, откуда можно одной командой загружать сотни предварительно собранных и оптимизированных моделей — от легковесных tinyllama до мощных llama3:70b. Это избавляет от необходимости искать и проверять модели вручную.

3️⃣ REST API для интеграции. "Под капотом" Ollama запускается как локальный сервер, предоставляющий RESTful API на порту 11434. Это значит, что к нему могут обращаться любые внешние приложения — веб-интерфейсы, мобильные приложения, другие сервисы и скрипты, превращая локальную модель в мощный бэкенд для самых разных задач.

4️⃣ Кроссплатформенность. Изначально появившись для macOS и Linux, Ollama быстро расширила свою поддержку и на Windows, обеспечивая единый опыт работы с моделями на всех основных операционных системах, включая запуск в контейнерах Docker.

Таким образом, Ollama выполнила ту же роль, что и Apple в мире смартфонов — она не изобретала технологию заново, но упаковала ее в настолько простую и элегантную форму, что сделала мощный локальный ИИ по-настоящему доступным для миллионов.

Быстрый старт

Установка и первый диалог с моделью

Чтобы начать работу с Ollama, не требуется месяцев изучения или сложных конфигураций. Инструмент предлагает два основных пути установки, каждый из которых займет у вас буквально несколько минут. Выбор между ними зависит от ваших целей: быстро протестировать функционал или создать стабильную систему для постоянной работы.

Два пути установки

Нативный и контейнеризация

1️⃣ Первый путь — нативная установка — самый простой и быстрый способ для знакомства с платформой. Он идеально подходит для персонального использования или тестирования на виртуальной машине. Процесс максимально автоматизирован: достаточно выполнить в терминале Linux одну команду, которая скачает и установит все необходимые компоненты: curl -fsSL https://ollama.ai/install.sh | sh

После завершения установки сервис Ollama будет автоматически запущен и готов к работе. Главное преимущество этого метода — скорость и простота. Главный недостаток — меньшая изоляция от основной системы.

2️⃣ Второй путь — установка через Docker-контейнер — считается лучшей практикой для продакшн-среды и любых серверных развертываний. Контейнеризация обеспечивает полную изоляцию процесса Ollama от хост-системы, что повышает безопасность и стабильность. Это упрощает управление зависимостями, обновлениями и переносом приложения между разными серверами. Запуск сводится к команде вида docker run -d -p 11434:11434 --name ollama ollama/ollama.

Использование Docker особенно критично, если вы планируете интегрировать Ollama с другими веб-сервисами, так как оно позволяет легко управлять переменными окружения (например, тем самым OLLAMA_ORIGINS) и сетевыми настройками. Это более гибкий и профессиональный подход, хотя и требующий базового понимания принципов работы с контейнерами.

Первая команда

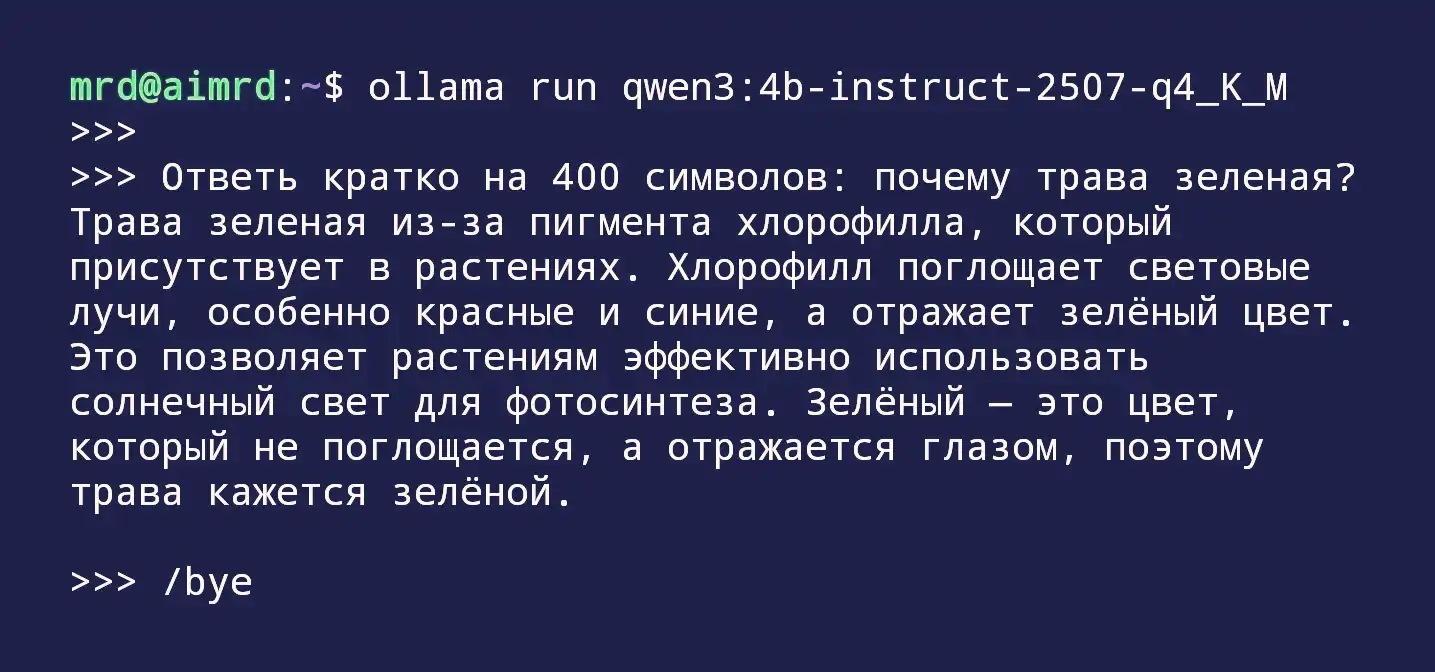

ollama run [модель]

Независимо от выбранного способа установки, ваше первое взаимодействие с искусственным интеллектом начнется с команды ollama run. Эта команда — ваш ключ к сотням языковых моделей.

Например, выполнив ollama run llama2, вы запустите цепочку событий:

- Клиент Ollama проверит наличие модели

llama2в локальном хранилище. - Если модели нет, она будет автоматически загружена из официального репозитория (Ollama Library). Размер загружаемых файлов может составлять от 500 МБ для маленьких моделей до нескольких гигабайтов для крупных.

- После завершения загрузки модель будет загружена в оперативную память, и вы сразу же окажетесь в интерактивном чате. Вы можете задавать вопросы на английском или русском (если модель его поддерживает), просить написать код или просто общаться.

С этого момента ваш сервер превращается в полноценный AI-ассистент. Команда ollama run — это тестовый полигон, но настоящая мощь платформы раскрывается при использовании ее как сервера с API, к которому могут подключаться другие приложения и скрипты, открывая путь для сложной автоматизации.

Опубликовано: