llama.cpp: Скрытый движок локального ИИ

В мире искусственного интеллекта часто кажется, что все новшества приходят от технологических гигантов. Однако революцию в области локального запуска больших языковых моделей (LLM) начал скромный проект с непритязательным названием llama.cpp.

Проект, начатый одним энтузиастом, стал фундаментом для демократизации больших языковых моделей, позволив запускать их на обычном компьютере.

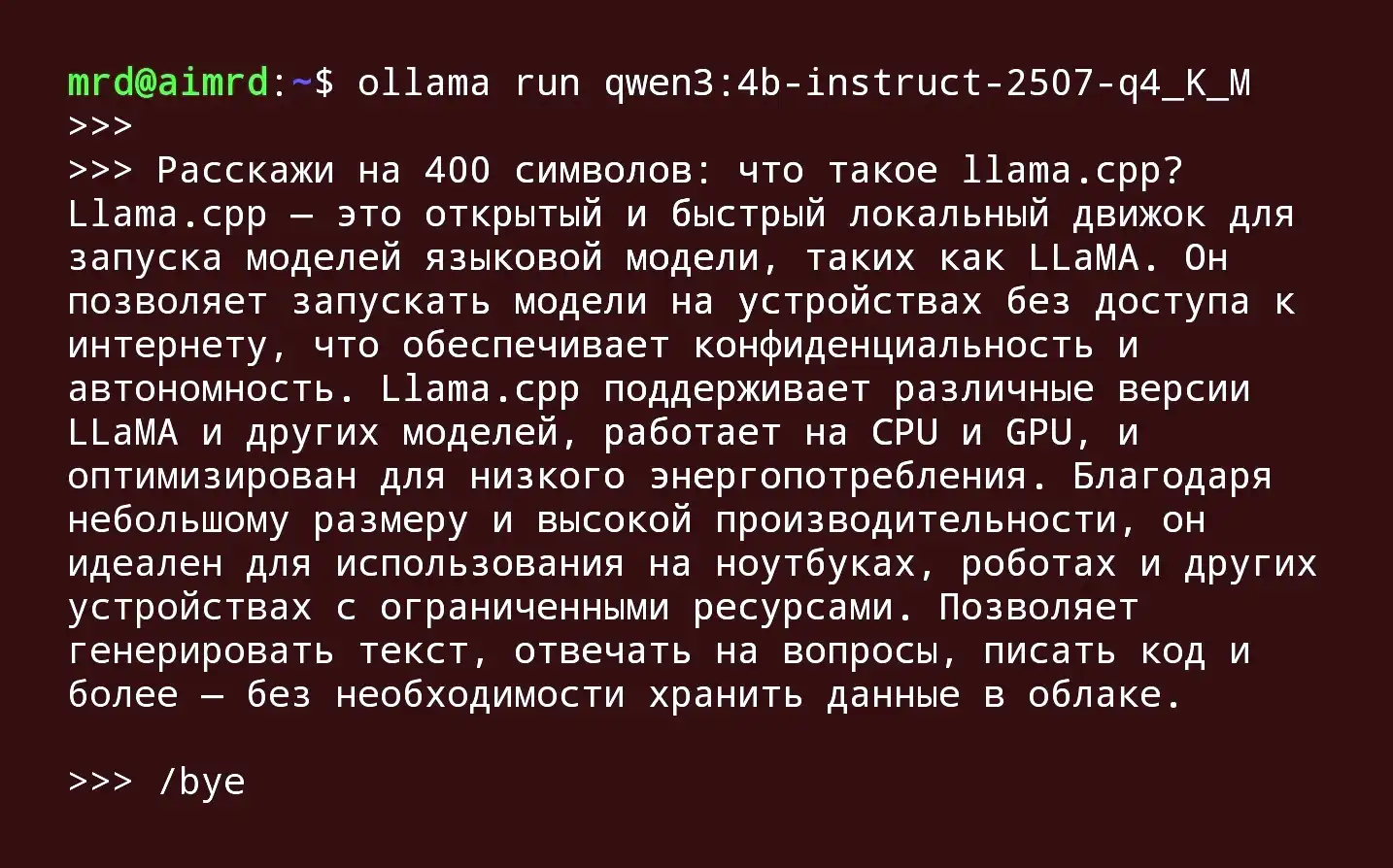

Созданный болгарским разработчиком Георгием Гергановым в 2023 году. Изначально это была попытка портировать модель LLaMA от Meta на C/C++, но результат превзошел все ожидания. Llama.cpp — это больше, чем просто библиотека; это вычислительный бэкенд с открытым исходным кодом, который лег в основу многих популярных пользовательских инструментов, включая Ollama. Понимание его устройства — ключ к глубокому погружению в то, как языковые модели выполняются на самом разном «железе», от обычных CPU до мощных GPU.

Что такое llama.cpp и почему он стал краеугольным камнем?

В отличие от традиционных реализаций, которые заточены под мощные графические процессоры и специализированные ускорители, llama.cpp был с самого начала ориентирован на работу на центральном процессоре (CPU). Такой подход позволил запускать LLM на обычных ноутбуках, настольных компьютерах и даже маломощных устройствах, сдевая технологии ИИ доступными для миллионов.

Ключевые принципы успеха llama.cpp:

1️⃣ Демократизация ИИ: Запуск моделей на потребительском «железе» без необходимости доступа к облачным сервисам или дорогостоящим GPU.

2️⃣ Максимальная производительность: Написание кода на C/C++ и его тщательная оптимизация под различные архитектуры процессоров (x86, ARM) позволили добиться высочайшей эффективности.

3️⃣ Кроссплатформенность: Благодаря использованию C/C++, llama.cpp легко компилируется и работает практически на любой операционной системе и может быть интегрирован в другие языки программирования через привязки (bindings).

Как llama.cpp работает с аппаратным обеспечением: магия под капотом

Изначально создававшийся для CPU, проект быстро эволюционировал, добавив поддержку различных вычислительных бэкендов. Это превратило его в универсальный инструмент, способный задействовать все ресурсы системы.

1. Квантизация и формат GGUF

Секрет компактности и эффективности

Одной из главных инноваций, без которых работа LLM на ограниченных ресурсах была бы невозможной, стала квантизация. Это процесс снижения точности численных представлений весов модели (например, с 16 бит до 8, 4 или даже 2 бит). В результате модель значительно уменьшается в размере и требует меньше памяти для работы, сохраняя при этом приемлемое качество генерации текста.

Для работы с такими сжатыми моделями был создан специальный бинарный формат GGUF (GPT-Generated Unified Format), который стал отраслевым стандартом для llama.cpp и всех основанных на нём проектов. Он оптимизирован для быстрой загрузки и содержит все необходимые метаданные для корректного запуска модели.

2. Поддержка разнообразного «железа»

Llama.cpp блестяще реализует принцип «правильный код на правильном ускорителе». Вот какие бэкенды он поддерживает:

1️⃣ CPU: Основной режим работы. Используются оптимизированные наборы инструкций (AVX, AVX2, AVX-512 для x86, NEON для ARM) для максимального ускорения вычислений на процессоре.

2️⃣ GPU (NVIDIA): Через бэкенд CUDA llama.cpp может переносить вычисления на видеокарты NVIDIA, что даёт колоссальный прирост в скорости.

3️⃣ GPU (AMD): Поддержка видеокарт AMD осуществляется через бэкенд HIP.

4️⃣ Apple Silicon: Для чипов Apple M-series используется высокооптимизированный бэкенд Metal, что позволяет в полной мере использовать возможности этой архитектуры.

5️⃣ Прочие бэкенды: Также имеется экспериментальная или основная поддержка Vulkan, SYCL (для Intel GPU), OpenCL и других.

На практике пользователь может указать, сколько слоё нейронной сети загрузить на GPU (--n-gpu-layers), а остальные оставить на CPU, реализуя гибридный режим работы, который критически важен для запуска больших моделей при ограниченной видеопамяти.

Сравнение llama.cpp и Ollama: движок и его удобная оболочка

Понимание разницы между этими двумя проектами критически важно. Если llama.cpp — это высокооборотистый двигатель, то Ollama — это автомобиль с автоматической коробкой передач, в который этот двигатель установлен.

Следующая таблица наглядно демонстрирует фундаментальные различия между двумя подходами:

| Критерий | Llama.cpp (Движок) | Ollama (Оболочка) |

|---|---|---|

| Уровень контроля | Высокий: полный контроль над всеми параметрами инференса | Низкий: ограниченный набор настроек, удобные предустановки |

| Производительность | Максимальная: прямая оптимизация под конкретное железо | Немного ниже: из-за слоя абстракции и универсальности |

| Простота использования | Сложная: требует компиляции, работы с командной строкой | Очень простая: установка одним кликом, интуитивные команды |

| Экосистема | Сообщество разработчиков и энтузиастов, фокус на низкоуровневых оптимизациях | Широкая пользовательская база, фокус на UX и интеграциях |

| Идеальный сценарий | Исследования, тонкая настройка, достижение максимальной скорости, интеграция в C++ приложения | Быстрый старт, эксперименты, разработка приложений с использованием API |

Статьи про Оллама

Ollama, будучи построенным на llama.cpp, принимает философию «работает из коробки». Он автоматически загружает модели, настраивает параметры по умолчанию и предоставляет простой API, абстрагируя пользователя от сложностей под капотом. Это не недостаток, а разный подход к решению задач.

Почему понимание llama.cpp важно для глубокого погружения?

Знание архитектуры и принципов работы llama.cpp даёт специалисту несколько весомых преимуществ:

1️⃣ Осознанный выбор железа: Понимая, как llama.cpp распределяет вычисления между CPU и GPU, можно собрать оптимальную систему под конкретные задачи, будь то сервер для инференса или рабочая станция для исследований.

2️⃣ Оптимизация производительности: Прямая работа с llama.cpp позволяет тонко настраивать параметры, такие как размер пакета (--ubatch-size), количество потоков или тип кэширования ключей и значений (--cache-type-k/v), выжимая из имеющегося оборудования максимум возможного.

3️⃣ Решение нестандартных задач: Для интеграции LLM в специализированные C++ приложения, создания кастомных пайплайнов обработки данных или экспериментов с новыми типами квантизации llama.cpp предоставляет необходимую низкоуровневую основу.

4️⃣ Преодоление ограничений готовых решений: Когда возможностей Ollama или LM Studio становится недостаточно, переход на чистый llama.cpp открывает второе дыхание, позволяя обойти ограничения, наложенные ради удобства.

Будущее llama.cpp и локального ИИ

Тенденция к перемещению ИИ на периферийные устройства (edge computing) только набирает обороты. Llama.cpp, с его фокусом на эффективность, минимализм и кроссплатформенность, идеально positioned в этой новой реальности. Активное сообщество постоянно добавляет поддержку новых моделей и архитектур, улучшает существующие бэкенды и исследует новые методы сжатия.

Этот проект — не просто инструмент, а изложение принципов: независимости от облачных инфраструктур, полного контроля над данными и их приватности, а также открытости и доступности передовых технологий. Благодаря работе Георгия Герганова и сотен контрибьюторов, сегодня любой человек, имеющий даже скромный ноутбук, может прикоснуться к миру больших языковых моделей и использовать их силу для своих проектов.

Таким образом, для того, чтобы по-настоящему понять экосистему локального ИИ, её необходимо начинать именно с изучения llama.cpp — того исходного проекта, который заложил фундамент и продолжает определять её развитие.

Опубликовано: