GGML/GGUF: Ключ к использованию LLM

Когда речь заходит о запуске больших языковых моделей (LLM) на персональных компьютерах, возникает фундаментальная проблема: эти модели, содержащие миллиарды параметров, традиционно требуют огромных вычислительных ресурсов и памяти.

Почему формат файлов имеет значение в мире ИИ

Локальное развертывание моделей сталкивается с ограничениями потребительского оборудования, где ресурсы оперативной памяти и вычислительной мощности не безграничны. Именно здесь на сцену выходит формат GGUF (GPT-Generated Unified Format) и его предшественник GGML — не просто как способ хранения файлов, а как революционный подход, делающий мощный ИИ доступным для всех.

GGUF стал отраслевым стандартом для эффективного хранения и развертывания больших языковых моделей, особенно в таких инструментах, как Ollama, которые позволяют любому пользователю легко запускать LLM на своем компьютере. Этот формат является ключом к пониманию трех критически важных аспектов современного ИИ: квантования, совместимости и эффективности работы как на CPU, так и на GPU. Давайте разберемся, как устроен этот формат и почему он так важен для демократизации искусственного интеллекта.

Что такое GGML и GGUF? Эволюция формата

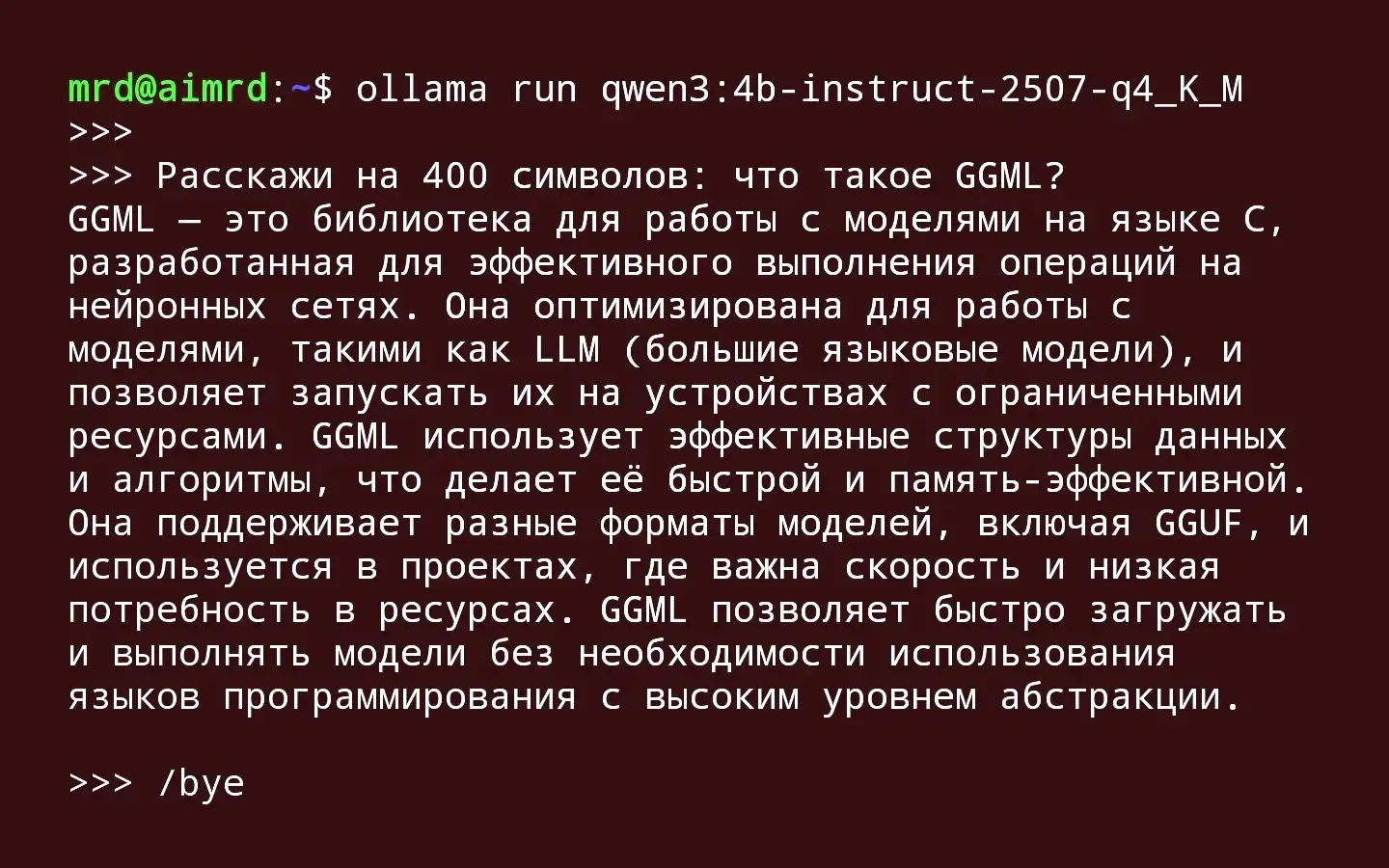

⏰ GGML (GPT-Generated Model Language) был первоначальной разработкой Георги Герганова (инициалы "GG" и составляют название формата). Это библиотека тензоров на C, ориентированная на машинное обучение, которая стала ранней попыткой создания формата файлов для моделей GPT.

Ранние инновации: GGML позволил впервые делиться сложными языковыми моделями в виде единого файла, который мог работать даже на CPU, что значительно расширило доступность ИИ.

Возникающие ограничения: Однако GGML страдал от проблем с гибкостью и расширяемостью. Добавление новой информации о модели часто приводило к проблемам совместимости со старыми версиями, а пользователям приходилось вручную настраивать различные параметры для корректной работы.

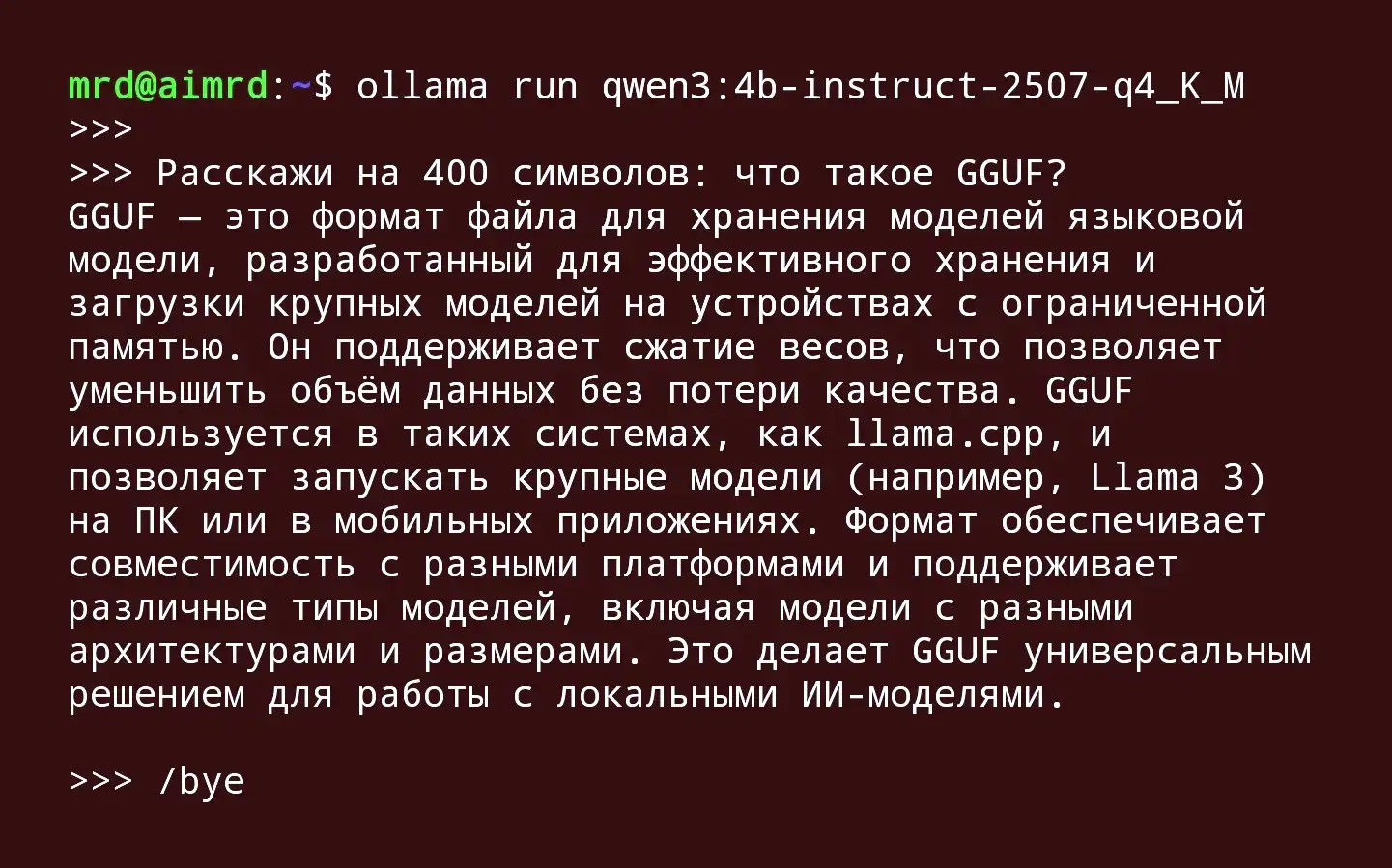

⏰ GGUF (GPT-Generated Unified Format), представленный 21 августа 2023 года, стал прямым преемником GGML, разработанным для преодоления этих ограничений. Этот новый формат был создан для обеспечения расширяемости — возможности добавлять новые функции, не нарушая совместимость со старыми моделями. GGUF также устранил критические изменения, которые затрудняли переход на новые версии в эпоху GGML, и поддерживает более широкий спектр моделей, выходя за рамки исключительно архитектуры LLaMA.

Квантование: Магия сжатия нейросетей

Квантование — это фундаментальная техника, лежащая в основе эффективности GGUF. Если говорить упрощенно, квантование — это процесс уменьшения точности чисел, используемых в весах модели.

Представьте себе высококачественное изображение в формате TIFF. Если преобразовать его в JPEG с разумной степенью сжатия, размер файла значительно уменьшится, а визуальное восприятие практически не пострадает. Аналогично, квантование преобразует веса модели, обычно представленные в 32-битных числах с плавающей запятой (занимающие 4 байта каждый), в 4-битные или даже 2-битные целочисленные форматы (занимающие 0.5 или 0.25 байта соответственно).

Практический эффект этого процесса поистине революционен:

1️⃣ Экономия памяти: Модель с 7 миллиардами параметров в формате FP32 занимает примерно 28 ГБ оперативной памяти. Та же модель, квантованная в 4-битный формат (INT4), занимает примерно 3.5 ГБ, что делает возможным ее запуск на обычном ноутбуке.

2️⃣ Ускорение вычислений: Центральные процессоры (CPU) обычно более оптимизированы для целочисленных операций, чем для операций с плавающей запятой. Работа с квантованными данными позволяет CPU использовать свои сильные стороны, что приводит к более быстрому выводу результата.

GGUF поддерживает широкий спектр уровней квантования (часто называемых "квантами"), каждый из которых предлагает различный баланс между размером модели и точностью.

Таблица: Распространенные уровни квантования в GGUF

| Уровень квантования | Средний размер 7B модели | Точность | Рекомендуемое использование |

|---|---|---|---|

| Q2_K (~2.6 бит/вес) | ~2.5 ГБ | Низкая | Сильно ограниченные ресурсы |

| Q4_K_M (~4.5 бит/вес) | ~4 ГБ | Сбалансированная | Оптимальный баланс для большинства задач |

| Q5_K_M (~5.5 бит/вес) | ~4.8 ГБ | Высокая | Максимальное сохранение качества |

| Q6_K (~6.6 бит/вес) | ~5.7 ГБ | Очень высокая | Профессиональные задачи, требующие высокой точности |

| Q8_0 (8 бит/вес) | ~7.2 ГБ | Почти полная | Наименьшая потеря качества, высокие требования к памяти |

Естественно, существует компромисс: более агрессивное квантование может незначительно повлиять на качество и связность выходных данных модели. Однако современные методы квантования, такие как использование матрицы важности (как в IQ4_XS) или супер-блоков, минимизируют эту потерю, делая ее часто незаметной для конечного пользователя.

Совместимость и экосистема: Единый формат для множества платформ

GGUF был разработан с акцентом на универсальность и простота использования, что привело к созданию богатой экосистемы инструментов и поддержки сообщества.

1️⃣ Кроссплатформенная поддержка: В отличие от многих других форматов, GGUF отлично работает на всех основных платформах — Windows, Linux и macOS (включая чипы Apple Silicon). Это делает его идеальным форматом для распространения моделей.

2️⃣ Инструменты и интеграции: GGUF стал основой для множества популярных проектов с открытым исходным кодом:

- Ollama: Пожалуй, самый простой способ для начинающих работать с GGUF-моделями, предоставляющий удобный интерфейс для загрузки, управления и запуска моделей.

- llama.cpp: Эталонная реализация для GGUF, библиотека на C/C++, которая обеспечивает высокоэффективный вывод на CPU.

- Text generation web UI, KoboldCpp, LM Studio: Эти инструменты предоставляют графические интерфейсы для взаимодействия с GGUF-моделями, часто с расширенными функциями.

Структура файла GGUF также способствует совместимости. Файл содержит три основных раздела: 1) Метаданные в формате ключ-значение (архитектура модели, версия, гиперпараметры), 2) Метаданные тензоров (информация о форме, типе данных и названиях тензоров) и 3) Непосредственно данные тензоров. Эта стандартизированная структура позволяет различным инструментам правильно интерпретировать и использовать одну и ту же модель.

Эффективность на CPU и GPU: Гибкость распределения вычислений

Одной из самых мощных особенностей экосистемы GGUF/llama.cpp является гибкость в распределении вычислений между процессором и видеокартой.

1️⃣ Оптимизация для CPU: Изначально GGML/GGUF были разработаны для эффективного выполнения на центральных процессорах, что демократизировало запуск LLM, делая его доступным для пользователей без мощных видеокарт. Использование памяти через mmap() позволяет быстро загружать модели, что критически важно для приложений, работающих в реальном времени.

2️⃣ Гибридный режим (CPU/GPU): Современные реализации, такие как llama.cpp, позволяют опционально загружать слои модели на GPU для ускорения вычислений. Например, для модели с 7 миллиардами параметров, состоящей из 35 слоев, можно указать, сколько слоев следует обрабатывать на GPU (n_gpu_layers), а сколько — на CPU. Это позволяет находить баланс между скоростью и потреблением памяти, адаптируя работу модели под конкретное оборудование.

3️⃣ Наблюдения из практики: Интересно, что некоторые пользователи сообщают о небольших различиях в качестве выходных данных в зависимости от конфигурации (только CPU, только GPU или гибридный режим). В некоторых случаях гибридная конфигурация может давать slightly более качественные результаты, что открывает пространство для дальнейшей оптимизации.

Практическое применение: Как начать работу с GGUF

Для тех, кто хочет испытать возможности GGUF на практике, Ollama является идеальным стартом. Этот инструмент абстрагирует множество технических сложностей, предоставляя простые команды для загрузки и запуска тысяч доступных моделей в формате GGUF.

Для более технически подкованных пользователей llama.cpp и связанные с ним библиотеки (такие как llama-cpp-python для Python) предлагают более детальный контроль над параметрами inference, такими как длина контекста, количество потоков и распределение слоев между CPU и GPU.

Множество предварительно квантованных моделей в формате GGUF доступны на платформе Hugging Face Hub, причем такие участники сообщества, как TheBloke, предоставляют десятки вариантов квантования для сотен различных моделей.

Будущее и значение GGUF

GGUF представляет собой не просто эволюцию формата файлов, а значительный шаг к устойчивому и адаптируемому будущему генеративных моделей. Его способность поддерживать широкий спектр моделей и конфигураций означает, что он не ограничен конкретными случаями использования или оборудованием.

Акцент на обратной совместимости минимизирует disruption при переходе на новые версии, что упрощает организациям процесс обновления без значительных простоев или перенастройки. Будучи открытым форматом, GGUF пользуется преимуществами совместного вклада сообщества open source, что способствует его постоянному развитию и широкому распространению.

Заключение

GGML и GGUF — это не просто технические термины в мире машинного обучения. Это ключевые технологии, которые сделали возможным локальный запуск больших языковых моделей на потребительском оборудовании. Понимание принципов квантования, совместимости и эффективности, которые воплощает этот формат, необходимо для любого, кто хочет по-настоящему разобраться в современном ландшафте открытого ИИ. Благодаря GGUF и таким инструментам, как Ollama, мощь больших языковых моделей становится доступной не только крупным технологическим компаниям, но и исследователям, разработчикам и энтузиастам по всему миру, способствуя дальнейшей демократизации искусственного интеллекта.

Опубликовано: