C++ и CUDA: «Рабочие лошадки» вычислений ИИ

В мире искусственного интеллекта, особенно в машинном обучении, все взгляды часто устремлены на высокоуровневые фреймворки: PyTorch, TensorFlow, Keras. Их удобный интерфейс и простота использования скрывают под собой сложный и мощный фундамент.

Это базис и делает возможным обучение и работу гигантских моделей. Этим фундаментом являются две «рабочие лошадки» высокопроизводительных вычислений: язык C++ и платформа CUDA. Именно их симбиоз позволяет таким библиотекам, как ggml и llama.cpp, эффективно работать на оборудовании NVIDIA, принося магию больших языковых моделей даже на ваш персональный компьютер.

C++: Несокрушимый хребет производительности

Почему C++ остается бессменным чемпионом в области низкоуровневых вычислений?

1️⃣ Прямой доступ к памяти. C++ предоставляет программисту полный контроль над оперативной памятью. Это критически важно для работы с огромными матрицами весов нейронных сетей, которые могут занимать десятки гигабайт. Точное управление размещением и перемещением данных позволяет избежать накладных расходов, неизбежных в языках с автоматическим управлением памятью, таких как Python.

2️⃣ Отсутствие накладных расходов. C++ компилируется напрямую в машинный код, который процессор выполняет без лишних интерпретаций. В контексте ИИ, где триллионы операций должны быть выполнены за минимальное время, эта скорость становится решающим фактором.

3️⃣ Богатейшие возможности оптимизации. Программист на C++ может использовать векторные инструкции (SSE, AVX), многопоточность и другие низкоуровневые техники, чтобы «выжать» из CPU максимум производительности.

Библиотеки вроде llama.cpp написаны на C++ именно по этим причинам. Они представляют собой высокооптимизированные «движки», которые с максимальной эффективностью выполняют базовые линейно-алгебраические операции — сложение, умножение матриц и т.д. — лежащие в основе всех нейронных сетей.

Однако, даже самый оптимизированный C++ код упирается в физические ограничения центрального процессора. Количество ядер в CPU измеряется десятками, и они предназначены для задач общего назначения. Здесь на сцену выходит вторая «лошадка» — CUDA.

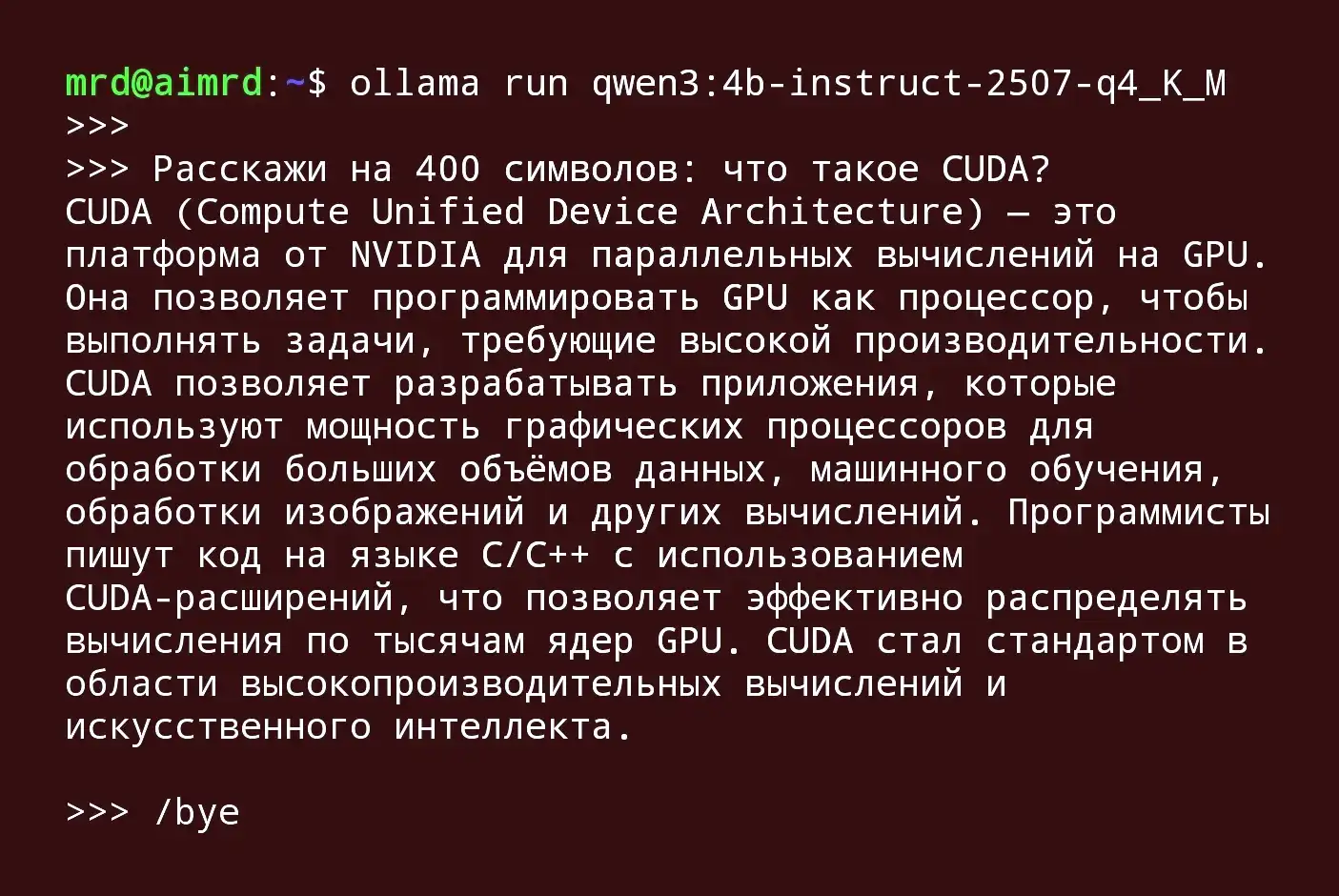

CUDA: Раскрывая мощь тысяч ядер

CUDA (Compute Unified Device Architecture) — это параллельная вычислительная платформа и программная модель от NVIDIA, которая позволяет использовать графические процессоры (GPU) для решения общематематических задач. В отличие от CPU, GPU изначально создавались для параллельной обработки миллионов пикселей. Эта архитектура идеально подходит для линейной алгебры.

Представьте себе операцию умножения матриц. Её можно разбить на тысячи независимых маленьких вычислений — перемножений строк на столбцы. CPU будет выполнять их последовательно или в небольшом количестве потоков. А GPU с его тысячами простых ядер может запустить эти вычисления одновременно.

Ключевые концепции CUDA, которые делают это возможным:

1. Иерархия параллелизма. Программа на CUDA (называемая kernel) запускается не одним потоком, а сеткой из тысяч потоков, организованных в блоки. Эта иерархия идеально соответствует структуре данных, например, когда каждому потоку поручается вычислить один элемент результирующей матрицы.

2. Иерархия памяти. Это, пожалуй, самый важный аспект для понимания производительности CUDA.

- Глобальная память: Большая, но относительно медленная память GPU. Сюда загружаются исходные данные (веса модели, входные векторы).

- Разделяемая память: Небольшой участок сверхбыстрой памяти, общий для всех потоков внутри одного блока. Программист может вручную кэшировать в ней часто используемые данные (например, фрагменты матриц), что радикально ускоряет вычисления.

- Регистры: Самая быстрая память, уникальная для каждого потока. Искусство программирования на CUDA заключается в умелом управлении этой памятью, чтобы минимизировать «простой» мощных вычислительных ядер в ожидании данных.

3. Потоки и асинхронность. Операции на GPU выполняются асинхронно относительно CPU. Это значит, что CPU может отдать команду GPU и продолжить свою работу, не дожидаясь результата. Правильное использование потоков позволяет одновременно вычислять на GPU и подготавливать следующие данные на CPU, скрывая задержки.

Симбиоз в действии: Пример llama.cpp

Давайте посмотрим, как эта связка работает в реальном проекте, например, в llama.cpp, который позволяет запускать модель LLaMA на обычном ПК.

1️⃣ C++ как дирижер: Код на C++ отвечает за загрузку модели из файла, управление контекстом對話, обработку входных данных пользователя и общую логику вывода токенов.

2️⃣ CUDA как оркестр: Когда наступает время выполнения прямого прохода нейронной сети (inference), C++ код передает управление CUDA-ядрум. Эти ядра — маленькие программы, написанные на специальном диалекте C++ с расширениями CUDA, — загружаются на GPU.

3️⃣ Параллельное чудо: На GPU огромные матрицы весов модели и входные активации разбиваются на фрагменты. Тысячи потоков одновременно начинают выполнять операции умножения и сложения. Критически важные этапы, такие как матричное умножение в полносвязных слоях или вычисление внимания в трансформерах, ускоряются в десятки и сотни раз благодаря параллелизму CUDA.

4️⃣ Возврат результата: Полученный результат (логит следующего токена) GPU возвращает в оперативную память, управляемую C++ кодом, который продолжает свою работу.

Без CUDA все эти вычисления легли бы на CPU и выполнялись бы мучительно долго. Без C++ было бы невозможно создать столь же эффективный, низкоуровневый и портируемый «хост», который управляет всем этим сложным процессом.

Заключение

C++ и CUDA — это не просто технологии из прошлого. Это живой и развивающийся фундамент современного ИИ. Пока мы общаемся с чат-ботами и генерируем изображения по тексту, в недрах наших компьютеров и серверов эти две «рабочие лошадки» без устали выполняют триллионы операций в секунду. Их симбиоз — это идеальный баланс между низкоуровневым контролем и невероятной параллельной вычислительной мощью, который продолжает раздвигать границы возможного в области искусственного интеллекта.

Опубликовано: